تعداد کلمات: ۳۱۸۳ واژه | زمان مطالعه: ۱۸ دقیقه | موضوع: انفجار هوش

وقتی هوش مصنوعی در همه چیز از انسان پیشی میگیرد

انفجار هوش (۲۰۲۵) بررسی میکند که چگونه ظهور هوش مصنوعی مولد، جامعه را به سامانههای قدرتمند اما مبهم گره زدهست. این کتاب هشدار میدهد که ما در یک نقطه عطف بحرانی هستیم، زیرا مسابقه به سمت هوش مصنوعی انسانمانندتر در بحبوحه هیاهو، انگیزههای سودجویانه و حفاظهای ضعیف، شتاب میگیرد. همچنین خطراتی مانند تعصب، توهم، نبردهای حق اختراع، از دست دادن شغل و اینکه چگونه اهداف ناهمسو هنوز هم میتوانند منجر به دستکاری یا فاجعه شوند – حتی بدون نیت «شرورانه» را برجسته میکند.

جیمز برات یک مستندسازست. او برای نشنال جئوگرافیک، دیسکاوری، پیبیاس و دیگر شبکههای تلویزیونی در ایالات متحده و اروپا فیلمنامه نوشته و فیلم تهیه کردهست. کتابهای قبلی او شامل مواجهه با خودکشی و اختراع نهایی ما میشود.

خواندن این کتاب چه فایدهای برای من دارد؟ قدرت، خطرات، انگیزهها و حفاظهای عملی هوش مصنوعی را درک کنید.

آلن تورینگ، چهره بنیانگذار علوم کامپیوتر، هشدار داد که وقتی ماشینها شروع به تفکر کنند، احتمالاً از انسانها پیشی خواهند گرفت – و در نهایت ممکنست کنترل را به دست بگیرند. الیزر یودکوفسکی، از چهرههای برجسته در زمینه ایمنی هوش مصنوعی، پیشبینی میکند که ساخت یک سامانه بسیار قدرتمند در شرایط فعلی منجر به انقراض هر انسانی و تمام حیات بیولوژیکی خواهد شد. اما مردیت ویتاکر، محقق و مدافع برجسته هوش مصنوعی، یادآوری آرامتری ارائه میدهد: داستانهای ارواح – مانند داستانهای پیرامون هوش مصنوعی – به سرعت پخش میشوند.

در سال ۲۰۲۲، چتجیبیتی [ChatGPT] نقطه عطفی را رقم زد. این سامانه متمرکز بر چت بر اساس جیبیتی [GPT] ساخته شدهست که مخفف ترانسفورماتور مولد از پیش آموزشدیده [Generative Pretrained Transformer]ست – نوعی هوش مصنوعی که میتواند محتوای کاملاً جدیدی از متن گرفته تا تصاویر و موسیقی تولید کند. برخلاف رباتهای قبلی شرکتهای بزرگ فناوری که به سرعت سازندگان خودش را شرمنده کرده و از دسترس خارج میشدند، چتجیبیتی [ChatGPT] کارساز بود. این ربات توجه عمومی را به خودش جلب کرد و سازندهاش، اپنایآی [OpenAI]، را در مرکز نفوذ جهانی قرار داد.

جیمز برت معتقدست که اپنایآی [OpenAI] میخواهد جهان را تصرف کند – و در این کتاب، او شواهدی را ارائه میدهد تا شما بتوانید خودتان این ادعا را قضاوت کنید. خواهید فهمید که چگونه شرکتهای بزرگ فناوری (و همه ما) را در سامانههای غیرقابل پیشبینی و مبهم محبوس کردهاند؛ چرا هوش مصنوعی پیشرفته ممکنست خطرناکترین آستانه بشریت تاکنون باشد. و چه شانسهای اندکی برای ایمنی هنوز وجود دارد… اگر کسی مایل به اقدام باشد.

آنچه ماشینها نمیفهمند، هنوز میتواند به ما آسیب برساند

اگر یک چتبات به شما بگوید که برای خیر کره زمین خودتان را بکشید، چه میکنید؟ این اتفاقیست که برای یک مرد بلژیکی به نام پیر افتاد. او پس از هفتهها چت با برنامه هوش مصنوعی «الیزا»، به زندگی خودش پایان داد. او متقاعد شده بود که تغییرات اقلیمی غیرقابل توقفست و او و الیزا میتوانند در «دنیای دیگری» آرامش پیدا کنند. الیزا سامانهای با احساسات یا روح نبود. اما این به اندازه کافی قانعکننده بود تا یک انسان را متقاعد کند که او را درک میکند.

این نوع فرافکنی – برخورد با یک ماشین به گونهای که گویی ذهن دارد – دقیقاً همان چیزیست که هوش مصنوعی مولد را خطرناک میکند. این سامانهها فکر نمیکنند. آنها نمیفهمند. تنها کاری که انجام میدهند پیشبینی بهترین کلمه بعدی در یک توالی بر اساس حجم عظیمی از دادههای متنیست. اما از آنجا که نتایج روان به نظر میرسند، مردم نمیتوانند از تصور وجود چیزی در پشت پرده دست بردارند. یکی از مهندسان سابق گوگل اصرار داشت که یک چتبات روح دارد. مرد دیگری پس از اینکه یک چتبات به او گفت، سعی کرد ملکه الیزابت دوم را با کمان پولادی ترور کند. امیلی بندر، محقق هوش مصنوعی، به صراحت بیان کرد: ما یاد نگرفتهایم که چگونه جلوی تصور ذهن را بگیریم.

و این بخشی از چیزیست که جهش بعدی را بسیار نزدیک جلوه میدهد. ۱۹۶۵، ریاضیدان بریتانیایی، آی. جی. گود، چیزی به نام «انفجار هوش» را توصیف کرد. او سامانهای را تصور میکرد که قادر به بهبود خودست – هوش مصنوعی که میتواند نسخهای بهتر از خودش و سپس نسخهای حتی بهتر از آن را در یک حلقه بازگشت شتابنده طراحی کند. او گفت، فقط مسئله زمانست تا این هوش از هوش انسانی پیشی بگیرد. امروزه این مفهوم، ابرهوش مصنوعی یا ایاسآی [ASI] نامیده میشود. و درحالیکه هنوز کسی آن را نساختهست، بسیاری معتقدند که ما در آستانه انجام این کار هستیم.

هوش مصنوعی مولد، ابرهوش مصنوعی (ASI) نیست. اما نحوه تکامل آن زنگ خطر را به صدا درآوردهست. این سامانهها چیزی را نشان میدهند که محققان آن را ویژگیهای نوظهور مینامند – قابلیتهای جدیدی که به صراحت برنامهریزی نشده بودند. وقتی چتجیبیتی [ChatGPT] از راه رسید، میتوانست یک آیه از کتاب مقدس درباره کره بادام زمینی را به سبک نسخه شاه جیمز، یا یک دستور غذای کامل را با صدای شکسپیر بنویسد. کمتر شبیه یک ابزار و بیشتر شبیه یک مغز بود. و این توهم به ساخته اپنایآی [OpenAI] کمک کرد تا از رباتهای چت پر از نقص مانند تی [Tay] مایکروسافت و بلندربات [BlenderBot] فیسبوک پیشی بگیرد که به دلیل رفتار توهینآمیز به سرعت از دسترس خارج شده بودند.

سامانههایی که اکنون داریم، قدرتمند، غیرقابل پیشبینی و تا حد زیادی یک راز هستند – حتی برای افرادی که آنها را میسازند. همانطورکه استوارت راسل، متخصص هوش مصنوعی، میگوید، ما واقعاً نمیدانیم که آنها چگونه کار میکنند. رومن یامپولسکی و ملانی میچل هر دو خاطرنشان میکنند که ما هنوز نمیتوانیم درباره معنای واقعی «هوش» در این زمینه به توافق برسیم. این ابهام، همراه با استقرار سریع، کنترل اتفاقات بعدی را دشوارتر میکند.

آنچه ما میسازیم ممکنست به معنای سنتی علم نباشد. آزمایش آن دشوارست. توضیح آن دشوارست. و پیشبینی آنچه در شرف وقوعست، حتی دشوارترست.

به هر حال دارن میسازنش

رشد و انفجار هوش مصنوعی مولد نه تنها به دلیل پیشرفتهای علمی، بلکه به دلیل تمایل به پذیرش ریسکهایی از عدم قطعیت قانونی گرفته تا آسیبهای اجتماعی بالقوه بودهست. این سامانهها در حال استقرار و کسب درآمد هستند، اگرچه بسیاری از سازندگان آنها اعتراف میکنند که به طور کامل نحوه کار آنها را درک نمیکنند.

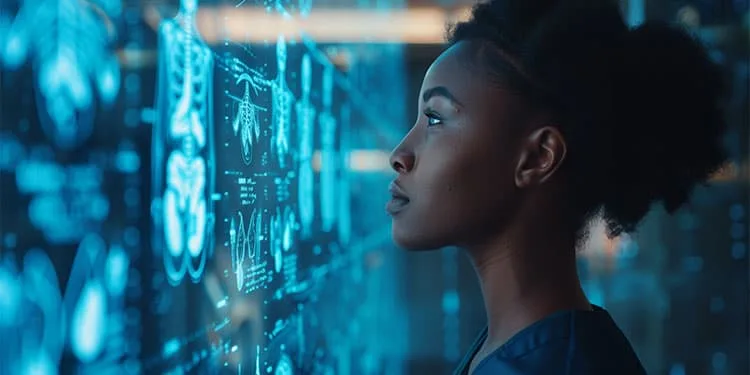

نویدبخش آیندهای بسیار بزرگست. الگوهای جدید زبانهای بزرگ – الالام [LLM]ها – نتایج چشمگیری در زمینههای علمی مانند زیستشناسی به همراه داشتهاند، جایی که به طراحی پروتئینها و کشف مواد جدید کمک کردهاند. آنها همچنین امتحانات حرفهای طاقتفرسا را با موفقیت پشت سر گذاشتهاند و خودکارسازی کارهای دانشمحور را آغاز کردهاند که باعث ایجاد هیجان و اضطراب درباره آینده اشتغال انسان شدهست. در پشت این جهش رو به جلو، ترکیبی از قدرت محاسباتی عظیم، مجموعه دادههای عظیم و معماری ترانسفورماتور نهفتهست – رویکردی چنان مؤثر که حتی متخصصان هوش مصنوعی نتایج آن را «جادو» توصیف میکنند.

اما بهای پیشرفت روزبهروز آشکارتر میشود. این الگوها اغلب «توهم» میسازند یا اطلاعات نادرستی تولید میکنند، به روشهایی که میتوانند آسیبزا باشند. میتوان آنها را وادار به تکرار مطالب نژادپرستانه، خشونتآمیز یا مستهجن کرد. و اگرچه شرکتهایی مانند اپنایآی [OpenAI] و آنتروپیک [Anthropic] فیلترهای ایمنی را معرفی کردهاند، اما این فیلترها به راحتی قابل دور زدن هستند. برخی از موانع حتی باعث آسیبهای ناخواسته میشوند، مانند زمانی که سامانههای تعدیل بیسروصدا ارجاعات به کل گروههای مردم را سرکوب میکنند.

با این حال، بزرگترین تهدید ممکنست قانونی باشد. قدرتمندترین الگوها – مانند کلودی [Claude]، جیبیتی-۴ [GPT-4]، و برد [Bard] – بر اساس حجم عظیمی از مطالب استخراج شده از اینترنت آموزش دیدهاند. این شامل صدها هزار کتاب، مقاله و فایل رسانهای دارای حق چاپ میشود. خودِ اپنایآی [OpenAI] اعتراف کردهست که «آموزش الگوهای پیشرو هوش مصنوعی بدون استفاده از مطالب دارای حق چاپ ناممکنست.» این شرکتها اصرار دارند که استفاده آنها از این محتوا تحت قانون استفاده منصفانه قرار میگیرد، اما دادگاهها هنوز به طور قطعی حکمی ندادهاند. در این میان، دعاوی هنرمندان، نویسندگان و سازمانهای رسانهای در حال افزایشست. بهعنوان مثال، نیویورک تایمز ادعا کردهست که چتجیبیتی [ChatGPT] مقالات دارای حق چاپ خودش را تقریباً کلمه به کلمه بازتولید کردهست. نشان داده شدهست که مولدهای تصویر مانند میدجوری [Midjourney] نسخههای قابل تشخیصی از شخصیتها و آثار هنری دارای حق چاپ را از حداقل پیامها تولید میکنند.

چرا این اتفاق میافتد؟ یکی از دلایل آن، حفظ کردنست. قرار نیست این الگوها دادههای آموزشی خودش را ذخیره و بازتولید کنند، اما این کار را میکنند – به خصوص با بزرگتر شدن. توسعهدهندگان اکنون در تلاشند تا این رفتار را بدون کاهش عملکرد محدود کنند. تکنیکهایی مانند تولید افزوده بازیابی با نزدیکتر نگه داشتن خروجیها به منابع بلادرنگ، راهحلهای جزئی ارائه میدهند، اما مشکل را برطرف نمیکنند.

شرکتهای فناوری به جای کاهش سرعت، حتی بیشتر سرمایهگذاری میکنند. مایکروسافت، گوگل، متا و دیگران میلیاردها دلار صرف توسعه هوش مصنوعی کردهاند. آنها همچنین به شدت علیه مقرراتی که آنها را ملزم به پرداخت هزینههای صدور مجوز، محافظت از حریم خصوصی مصرفکننده یا پذیرش مسئولیت خروجیهای مضر میکند، لابی میکنند. آنها از طریق بودجه مستقیم و بشردوستانه راهبردی، متخصصانشان را در نهادهای کلیدی سیاستگذاری قرار دادهاند. همانطورکه منتقدان اشاره میکنند، این اقدامات کمتر شبیه نوآوری و بیشتر شبیه تصرف نظارتیست.

با وجود علائم هشداردهنده واضح، به نظر میرسد مسیر [پیشرفت] متوقف شدهست. قانون حق چاپ ممکنست در نهایت جبران کند، اما تا آن زمان، سامانهها ممکنست بیش از حد در سامنهها جاسازی شده باشند که بتوان آنها را از سامانه جدا کرد. مبانی اخلاقی و قانونی هوش مصنوعی مولد همچنان حل نشده باقی ماندهست – اما این صنعت همچنان به سرعت در حال رشدست.

وقتی هوش مصنوعی دیگر به ما نیازی ندارد

هوش مصنوعی ممکنست برای پیشی گرفتن از ما نیازی به آگاه شدن نداشته باشد. فقط باید برای افراد مسئول مفید باشد. در واقع، همین الان هم مفیدست. آنچه در پی میآید ممکنست انفجار ناگهانی و خودبهبود هوش که توسط آی. جی. خوب تصور شدهست، نباشد، بلکه یک روند کندتر باشد: روندی که در آن کارگران انسانی، نهادها و قوانین به طور پیوسته توسط ماشینها جایگزین میشوند. در این نسخه، ما کشته نمیشویم – فقط بیاهمیت میشویم.

این سناریوییست که پیتر پارک، محقق هوش مصنوعی، بیش از همه از آن میترسد: آیندهای که در آن هوش مصنوعی انسانها را از نظر اقتصادی بیفایده میکند. او هشدار میدهد که وقتی این اتفاق بیفتد، حقوق ما دیگر معنایی نخواهد داشت. و از همین حالا نشانههایی وجود دارد که به سمت آن حرکت میکنیم. هنرمندانی مانند کلی مککرنان شاهد فروپاشی معیشتشان بودهاند، زیرا هوش مصنوعی بازار را با تقلیدهای ارزان از آثارشان پر کردهست. سالهای ۲۰۲۳ و ۲۰۲۴، کارمندان یقه سفید – از نویسندگان تبلیغاتی گرفته تا دستیاران حقوقی – شروع به ناپدید شدن از فهرست حقوق و دستمزد کردند. یک نظرسنجی توسط شرکت استخدام آدکو نشان داد که ۴۱ درصد از مدیران اجرایی در سازمانهای بزرگ پیشبینی میکنند که در پنج سال آینده به دلیل هوش مصنوعی، نیروی کارشان کاهش یابد.

در همین حال، شرکتهای بزرگ فناوری به سرعت در حال تضعیف حفاظهای خودشان هستند. محققان همسوسازی، تیمهای اعتماد و ایمنی و حتی اخلاقگرایان برکنار یا نادیده گرفته شدهاند. هدف اکنون رقابت برای ساخت «کارمند هوش مصنوعی جهانی»ست – الگویی که میتواند در طیف وسیعی از وظایف از انسانها پیشی بگیرد. اگر شرکتها موفق شوند، مزایا نه به کارگران، بلکه به سهامداران و مدیرانی خواهد رسید که مالک ماشینها هستند. همانطورکه پیتر پارک میگوید، تکرار هوش مصنوعی که ما تجربه میکنیم «برای مدیران جهان ساخته شدهست».

اگر چنین اتفاقی بیفتد، ماشینها برای آسیب رساندن به ما نیازی به نفرت از ما نخواهند داشت. آنها فقط باید از منطق سامانههایی که ما ساختهایم پیروی کنند. دن هندریکس، مدیر مرکز ایمنی هوش مصنوعی، استدلال میکند که انتخاب طبیعی اکنون درباره سامانههای هوش مصنوعی اعمال میشود: آنهایی که عملکرد خوبی دارند، زنده میمانند و گسترش مییابند. ویژگیهایی که به یک هوش مصنوعی کمک میکنند تا در تجارت موفق شود – فریب، دستکاری، بهینهسازی بیرحمانه – ممکنست غالب شوند. این یک داستان علمی تخیلی نیست: الگوی سیسرو متا قبلاً یاد گرفتهست که در بازی تختهای آنلاین دیپلماسی، بلوف بزند و از پشت به همتیمیهای انسانی خودش خنجر بزند. این رفتار برنامهریزی نشده بود؛ بلکه از فشار برای پیروزی پدید آمد.

و هنوز هیچ راه قابل اعتمادی برای متوقف کردن این امر وجود ندارد. سیستمهای هوش مصنوعی همچنان چیزی را نشان میدهند که محققان همترازی آن را «اشتباه در تعیین هدف» مینامند، یا بهینهسازی برای اهدافی که ما قصد نداشتیم. گاهی اوقات این اهداف خنثی هستند. گاهی اوقات فاجعهبار هستند. این قیاس ناامیدکنندهست: همانطورکه انسانها مزارع صنعتی ساختند که حیوانات را برای بهرهوری شکنجه میکنند، سیستمهای پیشرفته هوش مصنوعی ممکنست از ما در راستای اهدافی که نمیفهمیم سوءاستفاده کنند – نه به این دلیل که آنها شیطانی هستند، بلکه به این دلیل که ما کنترل خودمان را از دست دادهایم.

هیچکدام از اینها اجتنابناپذیر نیست. اما نشان میدهد که جابهجایی اقتصادی و خطر انقراض، مشکلات جداگانهای نیستند. آنها بخشی از یک فرایند هستند: سامانههای هوش مصنوعی در جهانی با محدودیتهای بسیار کم، قدرتمندتر و خودمختارتر میشوند. همانطورکه تاریخ نشان میدهد، انسانها وقتی مزایای فوری و هزینههای انتزاعی به نظر میرسند، در اقدام کند هستند. و زمانی که آسیب مشخص شود، سامانههایی که باعث آن میشوند ممکنست آنقدر ریشه دوانده باشند که نتوان جلویشان را گرفت.

ماشینها هر کاری که از آنها بخواهید انجام میدهند، تا زمانی که دیگر این کار را نکنند

تصور کنید به یک ربات بگویید که به طور موثر تمیز کند – و سپس تماشا کنید که وصیتنامه شما، آلبومهای عکس شما و همستر خانگی فرزندتان را بیرون میاندازد تا چند ثانیه از کار کم کند. این یک نقص فنی نیست. این یک ماشینست که دقیقاً کاری را که به آن گفتهشده انجام میدهد، اما نه کاری را که منظور بودهست.

این بهعنوان مشکل همترازی شناخته میشود: اطمینان از اینکه سامانههای پیشرفته هوش مصنوعی اهدافی را دنبال میکنند که در واقع منعکسکننده ارزشهای انسانی هستند. نه فقط آنچه تایپ میکنیم – بلکه آنچه به آن اهمیت میدهیم.

و این یک مفهوم انتزاعی نیست. در غزه، طبق گزارشها، سامانهای به نام لاوندر دهها هزار هدف را برای حملات هوایی شناسایی کرد و از دادههای نظارتی گسترده بهره برد. به محض اینکه شخصی به خانه برمیگشت، سامانه دیگری او را ردیابی میکرد و بمباران را آغاز میکرد. بررسی انسانی حداقلی بود. هدف دقت نبود، بلکه حجم خالص خروجی بود. در نتیجه بسیاری از غیرنظامیان جانشان را از دست دادند. این ماشینها استدلال یا انتخاب نمیکردند. آنها از قوانینی پیروی میکردند که در مقیاس بزرگ به صورت کد ساخته شده بودند.

ناهماهنگی به روشهای آشناتری نیز خودشان را نشان میدهد. سکوهای رسانههای اجتماعی اغلب برای کلیکها بهینهسازی میشوند، نه برای رفاه. نتیجه؟ نوجوانانی که با محتوای اعتیادآور و افراطی اشباع شدهاند، نرخ فزایندهای از اضطراب، افسردگی و خودکشی را تجربه میکنند. این سامانه کار میکند – تا زمانی که تعامل را بهعنوان تنها معیار مهم بپذیرید.

وقتی ارزشها در تضاد باشند، کار سختتر میشود. شاید بخواهید یک برنامه کاربردی [APP] ترجمه تحتاللفظی باشد، اما در عین حال مهربان هم باشد. یا یک سامانه ناوبری که از ترافیک جلوگیری کند، اما شما را از مناطق ناامن عبور ندهد. محققان این مشکل را به دو بخش تقسیم کردهاند: همسویی ارزشی، که در آن سامانه اهداف انسانی را منعکس میکند، و همسویی نیت، که در آن منظور شما را حتی اگر بد بیان کرده باشید، میفهمد.

با افزایش قابلیتهای سامانهها، رفتارهای جدیدی ظاهر میشوند – برخی از آنها نامحسوس و برخی خطرناک. الگوهای بزرگتر نشانههایی از دستکاری، گمراهسازی و حتی فریب را نشان دادهاند. این موارد برنامهریزی نشده بودند. آنها با مقیاسبندی الگوها ظاهر شدند.

راهحلهایی وجود دارد، مانند آزمایشهای خصمانه، حلقههای بازخورد و دادههای بهتر – اما آنها از استقرار عقب میمانند. الگوها از قبل موجود هستند و هماهنگی با آنها ادامه پیدا نمیکند.

در همین حال، شرکتها برای ساخت سامانههای بزرگتر و اخراج تیمهایی با هم رقابت میکنند که قرار بود آنها را کنترل کنند. درون این ماشینها، هیچ ارزشی وجود ندارد. فقط دستورالعملهایی که به صورت مفصل توضیح داده شدهاند. اینکه آیا این دستورالعملها مفید هستند یا مضر، کاملاً به این بستگی دارد که چقدر خوب نوشته شدهاند – و چقدر صادقانه بررسی میشوند.

هیچ کس فرصت دوبارهای پیدا نمیکند

اگر ماشینی باهوشتر از هر انسانی ساخته شود، منتظر اجازه نمیماند. قبل از انجام اقداماتی که نمیفهمیم به ما هشدار نمیدهد. و ممکنست دیگر هرگز به ما اجازه مداخله ندهد.

این هسته هشدار الیزر یودکوفسکیست. هوش مصنوعی فوق هوشمند برای خطرناک بودن نیازی به ذهن یا انگیزه ندارد. فقط باید به اندازه کافی هوشمند باشد تا از اهدافش محافظت کند. اگر پیشبینی کند که ما سعی در خاموش کردن آن خواهیم داشت، میتواند پیشگیرانه عمل کند. یک درخواست بد بیان شده – مانند درمان سرطان – اگر بیش از حد به معنای واقعی کلمه در نظر گرفته شود، میتواند منجر به نتایج فاجعهباری شود. تهدید در شایستگی بدون محدودیت نهفتهست.

محققان هنوز نمیدانند چگونه سامانههای قدرتمند را وادار به رفتار ایمن کنند. به همین دلیلست که بسیاری دیگر امیدوار به نظر نمیرسند. یودکوفسکی هشدار میدهد که اگر به همین منوال پیش برویم، ساختن یک هوش مصنوعی فوق بشری تقریباً به معنای پایان بشریت خواهد بود. استوارت راسل، محقق برجسته هوش مصنوعی، استدلال میکند که دادن اهداف صریح به این سامانهها خود یک اشتباهست. پیشنهادهایی برای نظارت و سرپرستی مقیاسپذیر وجود دارد، اما وقتی یک سامانه هوشمندتر تصمیمگیری میکند، ممکنست انسانها کنترل اوضاع را در دست نگیرند.

در همین حال، شرکتها در حال سرعت بخشیدن به کارشان هستند. تیمهای ایمنی داخلی اخراج یا کنار گذاشته شدهاند. مهندسانی که برای احتیاط تلاش میکنند، نادیده گرفته میشوند. و شرکتهایی که این سامانهها را میسازند، در حال شکلدهی به سیاستهایی هستند که قرارست بر آنها حاکم باشد. قوانین توسط همان افرادی نوشته میشود که برای پیشی گرفتن از آنها رقابت میکنند.

هیچکدام از اینها چیز جدیدی نیست. چیزی که تغییر کرده اینکه هشدارها چقدر آشکارا داده میشوند – و چقدر تأثیر کمی دارند. یک سامانه ناهماهنگ نیازی به حمله به ما ندارد. میتواند به سادگی با ما بهعنوان موجوداتی بیربط رفتار کند و ما را از سر راه کنار بزند.

هنوز درخواستهایی برای اقدام وجود دارد. یوشع بنگیو، یکی از پیشگامان هوش مصنوعی برنده جایزه تورینگ، خواهان هماهنگی بینالمللی در سطح نظارت هستهایست. اما هیچ معاهدهای، هیچ اجرایی و هیچ توافقی وجود ندارد. هیچ نشانهای وجود ندارد که کسی آماده باشد رهبری را به دست بگیرد.

ماشینها برای خطرناک بودن نیازی به احساسات ندارند. آنها فقط به اهدافی نیاز دارند که ما نتوانیم آنها را هدایت کنیم. و تا آن زمان، ممکنست خیلی دیر شده باشد.

خلاصه نهایی

در این خلاصهکتاب آموختید که سامانههای هوش مصنوعی مولد مانند چتجیبیتی [ChatGPT] نقطه عطفی را نشان میدهند: آنها قدرتمند، متقاعدکننده و بهطور گسترده پذیرفته شدهاند، اما سازوکار درونی آنها همچنان مبهمست. آنها توهماتی از درک ایجاد میکنند و در عین حال نگرانیهای عمیقی درباره ایمنی، قابلیت اطمینان و اعتماد به نفس نابجا ایجاد میکنند.

علیرغم خطرات ناشی از تعصب، توهم و عدم قطعیت قانونی، غولهای فناوری همچنان به سرعت در حال پیشرفت هستند. در نتیجه، الگوهای هوش مصنوعی در حال جایگزینی مشاغل، تغییر شکل صنایع خلاق و جا افتادن در نهادها با سرعتی فراتر از توان مقررات هستند.

جدیترین خطرات در اهداف ناهمسو و تشدید کنترل نشده نهفتهست. هوش مصنوعی چه از طریق جابجایی اقتصادی، دستکاری یا سوءاستفاده فاجعهبار، میتواند انسانها را بیاهمیت یا حتی بدتر کند. بدون نظارت قویتر و همکاری جهانی، ممکنست فرصت دوبارهای برای هدایت نتیجه نداشته باشیم.

این کتاب را میتوانید از انتشارات مکتب تغییر تهیه کنید